En este artículo, vamos a discutir cómo cambiar la escala de un tensor en el rango [0, 1] y sumar a 1 en PyTorch usando Python .

Método softmax()

El método Softmax() nos ayuda a reescalar un tensor de n-dimensional a lo largo de una dimensión particular, los elementos de este tensor de entrada están entre el rango de [0,1] y la suma a 1. Este método devuelve un tensor de la misma forma y dimensión que el tensor de entrada y los valores se encuentran dentro del rango [0, 1]. antes de continuar, veamos la sintaxis del método dado.

Sintaxis: torch.nn.Softmax(dim)

Parámetros:

- dim: El dim es la dimensión en la que calculamos el Softmax.

Devoluciones: devolverá un tensor con la misma forma y dimensión que el tensor de entrada y los valores están entre el rango [0, 1].

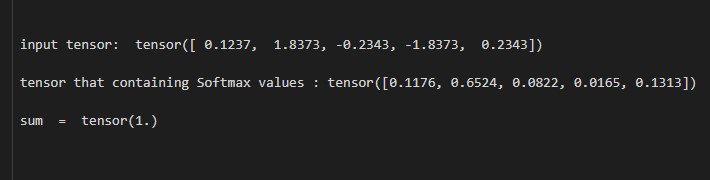

Ejemplo 1: En este ejemplo, cambiamos la escala de un tensor 1D en el rango [0, 1] y sumamos 1.

Python

# import required libraries

import torch

# define a tensor

input_tens = torch.tensor([0.1237, 1.8373,

-0.2343, -1.8373,

0.2343])

print(" input tensor: ", input_tens)

# Define the Softmax function

softmax = torch.nn.Softmax(dim=0)

# Apply above defined Softmax function

# on input tensor

output = softmax(input_tens)

# display tensor that containing Softmax values

print(" tensor that containing Softmax values: ",

output)

# display sum

print(" sum = ", output.sum())

Producción:

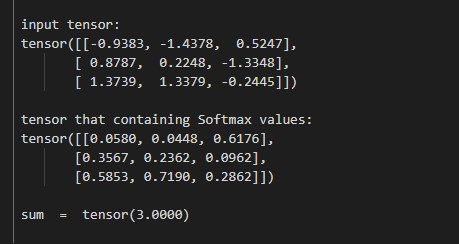

Ejemplo 2: En este ejemplo, cambiamos la escala de un tensor 2D en el rango [0, 1] y sumamos 1.

Python

# import required libraries

import torch

# define a tensor

input_tens = torch.tensor([[-0.9383, -1.4378, 0.5247],

[0.8787, 0.2248, -1.3348],

[1.3739, 1.3379, -0.2445]])

print("\n input tensor: \n", input_tens)

# Define the Softmax function

softmax = torch.nn.Softmax(dim=0)

# Apply above defined Softmax function on

# input tensor

output = softmax(input_tens)

# display tensor that containing Softmax values

print("\n tensor that containing Softmax values: \n", output)

# display sum

print("\n sum = ", output.sum())

Producción:

Publicación traducida automáticamente

Artículo escrito por mukulsomukesh y traducido por Barcelona Geeks. The original can be accessed here. Licence: CCBY-SA