El rastreo web es el proceso de indexación de datos en páginas web utilizando un programa o script automatizado, conocido como rastreadores, arañas o robots araña. Este rastreador recopila mucha información que a menudo es útil en las pruebas de penetración de aplicaciones web y la recompensa por errores. GoSpider es también el rastreador web más rápido que está diseñado en el lenguaje Golang. La herramienta GoSpider es de código abierto y de uso gratuito. GoSpider también admite el escaneo de múltiples dominios de destino simultáneamente y permite guardar los resultados en el almacenamiento local.

Nota: Como GoSpider es una herramienta basada en el lenguaje Golang, debe tener un entorno Golang en su sistema. Así que consulte este enlace para instalar Golang en su sistema. – Instalación de Go Lang en Linux

Características de la herramienta GoSpider

- La herramienta GoSpider es la herramienta de rastreo web más rápida.

- La herramienta GoSpider admite el análisis de archivos robots.txt.

- La herramienta GoSpider tiene la función de generar y verificar enlaces desde archivos JavaScript.

- La herramienta GoSpider es compatible con Burp Suite Input for Scan.

- La herramienta GoSpider ayuda a escanear múltiples dominios de destino simultáneamente.

- La herramienta GoSpider puede detectar subdominios desde la fuente de respuesta.

Instalación de la herramienta GoSpider en el sistema operativo Kali Linux

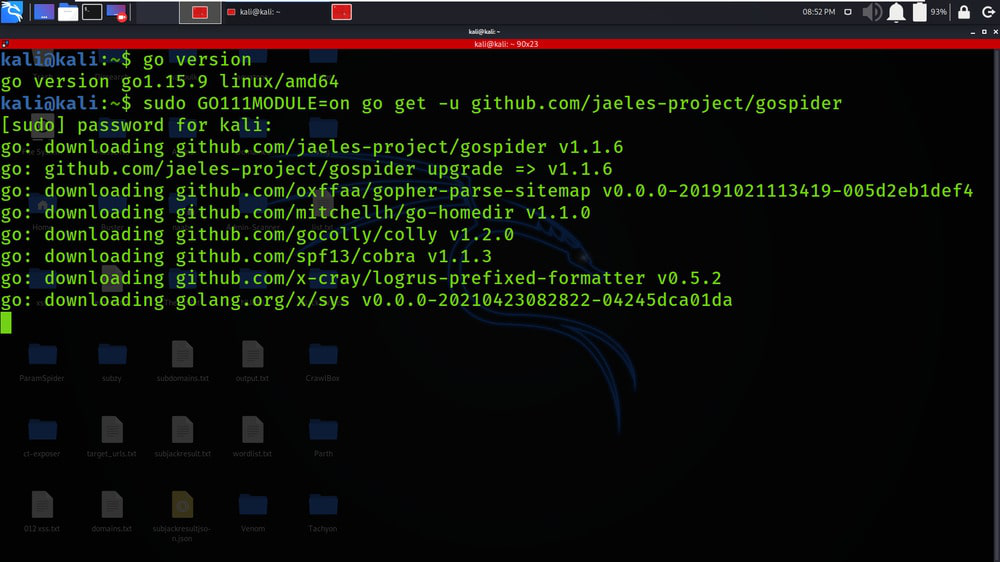

Paso 1: si ha descargado Golang en su sistema, verifique la instalación verificando la versión de Golang, use el siguiente comando.

go version

Paso 2: obtenga el repositorio GoSpider o clone la herramienta GoSpider de Github, use el siguiente comando.

sudo GO111MODULE=on go get -u github.com/jaeles-project/gospider

Paso 3: copie la ruta de la herramienta en el directorio /usr/bin para acceder a la herramienta desde cualquier lugar, use el siguiente comando

sudo cp /go/bin/gospider /usr/local/go/bin/

Paso 4: verifique la versión de la herramienta GoSpider usando el siguiente comando.

gospider --version

Paso 5: Verifique la página del menú de ayuda para comprender mejor la herramienta GoSpider, use el siguiente comando.

gospider -h

Trabajar con la herramienta GoSpider en Kali Linux

Ejemplo 1: ejecutar con un solo sitio

gospider -s «https://geeksforgeeks.org» -o geeksforgeeks_output.txt -c 10 -d 1

1. En este ejemplo, rastrearemos enlaces desde un solo dominio de destino (geeksforgeeks.org). La etiqueta -s se utiliza para especificar el dominio de destino.

2. En la siguiente captura de pantalla, los resultados del proceso de rastreo se almacenan en el archivo de texto que se puede utilizar para realizar más análisis.

Ejemplo 2: ejecutar con la lista de sitios

gospider -s list.txt -o output -c 10 -d 1

1. En este ejemplo, realizaremos un rastreo en varios dominios de destino. En la siguiente captura de pantalla, se muestra un archivo de texto que consta de varios dominios de destino.

2. En la siguiente captura de pantalla, puede ver que los resultados del proceso de rastreo en los múltiples objetivos se muestran en el terminal.

3. En la siguiente captura de pantalla, puede ver que se crea un archivo de texto separado para los dominios especificados en la primera captura de pantalla.

4. En la siguiente captura de pantalla, puede ver que los resultados del rastreo se guardan en los archivos asociados con su dominio. (Los resultados de geeksforgeeks.org se guardan en geeksforgeeks.org_results, txt).

Ejemplo 3: ejecutar con 10 sitios al mismo tiempo con 5 bots en cada sitio

gospider -S targets.txt -o output1 -c 10 -d 1 -t 20

1. En este ejemplo, rastrearemos los 10 sitios web diferentes o dominios de destino simultáneamente. En la siguiente captura de pantalla, los dominios de destino se guardan en el archivo targets.txt.

2. En la siguiente captura de pantalla, proporcionamos el comando y se inicia el proceso de rastreo.

3. En la siguiente captura de pantalla, puede ver que GoSpider está rastreando varios dominios de destino simultáneamente. En la siguiente captura de pantalla, los dominios tesla.com, geeksforgeeks.org, yahoo.com, etc. se rastrean simultáneamente.

4. Aunque el rastreo se realiza simultáneamente, los resultados de cada dominio de destino se guardan en archivos de texto separados asociados con su nombre. En la siguiente captura de pantalla, los resultados de 10 dominios de destino se guardan en 10 archivos de texto diferentes junto con sus nombres.

5. En la siguiente captura de pantalla, hemos abierto el archivo google.com_results.txt que contiene todos los datos rastreados.

Ejemplo 4: obtenga también URL de terceros (Archive.org, CommonCrawl.org, VirusTotal.com, AlienVault.com)

gospider -s "https://geeksforgeeks.org/" -o output -c 10 -d 1 --other-source

1. En este ejemplo, estamos tratando de obtener enlaces de terceros externos.

2. En la siguiente captura de pantalla, los resultados se guardan en el archivo de texto asociado con el nombre de dominio de destino.

Ejemplo 5: obtenga también URL de terceros (Archive.org, CommonCrawl.org, VirusTotal.com, AlienVault.com) e incluya subdominios

gospider -s “https://google.com/” -o salida2 -c 10 -d 1 –otra-fuente –include-subs

1. En este ejemplo, rastrearemos los datos de los subdominios que están asociados con el dominio principal proporcionado. En la siguiente captura de pantalla, estamos rastreando google.com, ya que tiene un alcance enorme.

2. En la siguiente captura de pantalla, puede ver que los subdominios también se incluyen en el proceso de rastreo.

Ejemplo 6: Usar encabezado/cookies personalizados

gospider -s “https://geeksforgeeks.org/” -o salida3 -c 10 -d 1 –otra-fuente -H “Aceptar: */*” -H “Prueba: prueba” –cookie “pruebaA=a; pruebaB=b”

1. En este ejemplo, proporcionamos información adicional en forma de cookies. Hemos utilizado la etiqueta –cookie para proporcionar los valores de la cookie.

Ejemplo 7 : extensión de archivo/URL de la lista negra.

gospider -s “https://geeksforgeeks.org” -o salida -c 10 -d 1 –lista negra “.(woff|pdf)”

1. En este ejemplo, estamos filtrando o agregando algunas extensiones y URL a la lista negra. Todos estos datos en la lista negra se excluirán o ignorarán al recuperar los resultados.

Publicación traducida automáticamente

Artículo escrito por gauravgandal y traducido por Barcelona Geeks. The original can be accessed here. Licence: CCBY-SA