Grandes datostrata con grandes conjuntos de datos o trata con el complejo que maneja el software de aplicación de procesamiento de datos tradicional. Tiene tres conceptos clave como volumen, variedad y velocidad. En volumen, determinando el tamaño de los datos y en variedad, los datos serán categorizados, los medios determinarán el tipo de datos como imágenes, PDF, audio, video, etc. y en velocidad, velocidad de transferencia de datos o velocidad de procesamiento y análisis de datos. ser considerado. Los grandes datos funcionan en grandes conjuntos de datos y pueden ser no estructurados, semiestructurados y estructurados. Incluye los siguientes parámetros clave al considerar los grandes datos como la captura de datos, la búsqueda, el almacenamiento de datos, el intercambio de datos, la transferencia, el análisis de datos, la visualización y la consulta, etc. En el caso del análisis, se utilizará en las pruebas A/B. , aprendizaje automático y procesamiento de lenguaje natural, etc.

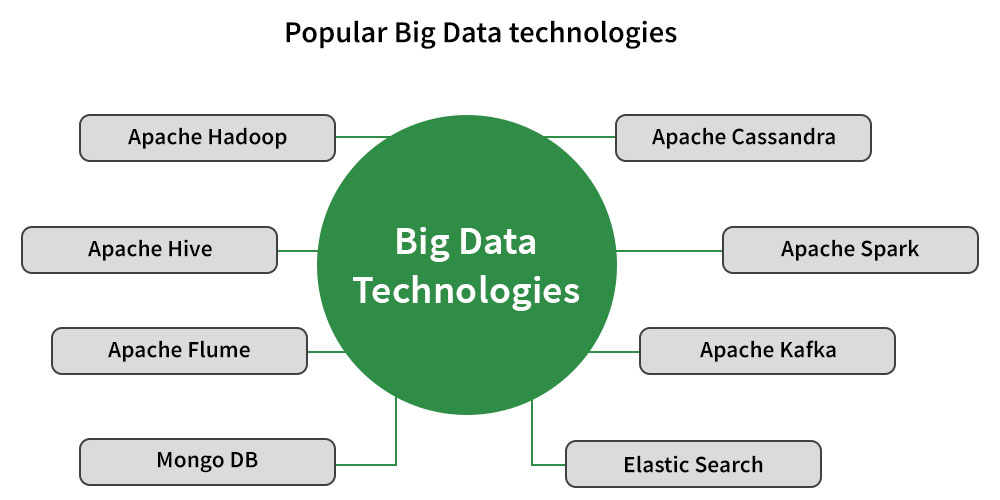

Algunas tecnologías populares de Big Data:

Aquí, analizaremos en detalle la descripción general de estas tecnologías de big data y nos centraremos principalmente en la parte general de cada tecnología, como se mencionó anteriormente en el diagrama.

1. Apache Cassandra : es una de las bases de datos No-SQL que es altamente escalable y tiene alta disponibilidad. En esto, podemos replicar datos en múltiples centros de datos. Se admite la replicación en varios centros de datos. En Cassandra, la tolerancia a fallas es uno de los grandes factores en los que los Nodes defectuosos se pueden reemplazar fácilmente sin tiempo de inactividad.

2. Apache Hadoop : Hadoop es una de las tecnologías de big data más utilizadas que se utiliza para manejar datos a gran escala, grandes sistemas de archivos mediante el uso del sistema de archivos Hadoop, que se denomina HDFS, y una función similar al procesamiento paralelo mediante el marco MapReduce de Hadoop. Hadoop es un sistema escalable que ayuda a tener una solución escalable que maneja grandes capacidades y capacidades. Por ejemplo: si ve casos de uso reales como NextBio está usando Hadoop MapReduce y HBase para procesar conjuntos de datos de varios terabytes del genoma humano.

3. Apache Hive : se utiliza para resumir datos y realizar consultas ad hoc, lo que significa consultar y analizar fácilmente Big Data. Está construido sobre Hadoop para proporcionar resúmenes de datos, consultas ad-hoc y el análisis de grandes conjuntos de datos utilizando un lenguaje similar a SQL llamado HiveQL. No es una base de datos relacional ni un lenguaje para consultas en tiempo real. Tiene muchas características como: diseñado para OLAP, lenguaje de tipo SQL llamado HiveQL, rápido, escalable y extensible.

4. Apache Flume: es un sistema distribuido y confiable que se utiliza para recopilar, agregar y mover grandes cantidades de datos de registro desde muchas fuentes de datos hacia un almacén de datos centralizado.

5. Apache Spark : el principal objetivo de Spark para acelerar el proceso del software de computación Hadoop, y es presentado por Apache Software Foundation. Apache Spark puede funcionar de forma independiente porque tiene su propia administración de clústeres, y no es una versión actualizada o modificada de Hadoop y, si profundiza, puede decir que es solo una forma de implementar Spark con Hadoop. La idea principal para implementar Spark con Hadoop de dos maneras es para almacenamiento y procesamiento. Por lo tanto, de dos maneras, Spark usa Hadoop con fines de almacenamiento solo porque Spark tiene su propio cálculo de administración de clústeres. En Spark, incluye consultas interactivas y procesamiento de secuencias, y la computación en clúster en memoria es una de las características clave.

6. Apache Kafka : es un sistema de mensajería de publicación-suscripción distribuida y, más específicamente, puede decir que tiene una cola robusta que le permite manejar un gran volumen de datos, y puede pasar los mensajes de un punto a otro como puede. decir de un emisor a un receptor. Puede realizar el cálculo de mensajes en modo fuera de línea y en línea, es adecuado para ambos. Para evitar la pérdida de datos, los mensajes de Kafka se replican dentro del clúster. Para el análisis de datos de transmisión en tiempo real, integra Apache Storm y Spark y se basa en el servicio de sincronización de ZooKeeper.

7. MongoDB : se basa en multiplataforma y funciona en un concepto como colección y documento. Tiene almacenamiento orientado a documentos, lo que significa que los datos se almacenarán en formato JSON. Puede ser un índice en cualquier atributo. Tiene características como alta disponibilidad, replicación, consultas enriquecidas, soporte de MongoDB, Auto-Sharding y actualizaciones rápidas en el lugar.

8. ElasticSearch : es un sistema distribuido en tiempo real y un motor de análisis y búsqueda de texto completo de código abierto. Tiene características como el factor de escalabilidad es alto y datos estructurados y no estructurados escalables hasta petabytes. Se puede usar como un reemplazo de MongoDB, RavenDB que se basa en almacenamiento basado en documentos. Para mejorar el rendimiento de la búsqueda, utiliza la desnormalización. Si ve el caso de uso real, entonces es un motor de búsqueda empresarial y grandes organizaciones que lo utilizan, por ejemplo, Wikipedia, GitHub.

Publicación traducida automáticamente

Artículo escrito por Ashish_rana y traducido por Barcelona Geeks. The original can be accessed here. Licence: CCBY-SA