En los últimos años, la revolución de la IA está ocurriendo en todo el mundo, pero en los últimos meses, si eres un entusiasta de la tecnología, has oído hablar de GPT-3. El Transformador Generativo Preentrenado 3 (GPT-3) es un modelo de lenguaje que utiliza la técnica del Transformador para realizar varias tareas. Es el modelo de predicción de idiomas de tercera generación creado por OpenAI (un laboratorio de investigación de IA y una empresa de código abierto). Tiene 175 mil millones de parámetros masivos, que es aproximadamente 117 veces mayor que su predecesor, GPT-2 (creado en 2019), que tiene aproximadamente 1,5 mil millones de parámetros. GPT-3 se lanza en mayo de 2020. GPT-3 es 10 veces más grande que el segundo modelo de idioma más grande, Turing NLG de Microsoft, que tiene 17 000 millones de parámetros. Está entrenado en un conjunto de datos de medio billón de palabras. Genera la salida calculando estadísticamente la respuesta más cercana a la entrada dada.

Casos de uso de GPT-3:

- Funciona como un motor de búsqueda.

- Un chatbot que te permite hablar con personajes históricos

- Resuelva acertijos de lenguaje y sintaxis a partir de unos pocos ejemplos.

- Puede generar código basado en descripciones de texto.

- Puede responder consultas médicas.

- Puede componer tablaturas de guitarra.

- Puede escribir ficción e historias creativas.

- Puede autocompletar imágenes y texto.

- Puede producir poesía

- Puede traducir

Criterios de evaluación para modelos GPT : los investigadores evalúan el rendimiento de los modelos GPT en varios puntos de referencia y cuatro tipos de tareas de comprensión del lenguaje:

- Inferencia de lenguaje natural,

- respuesta a preguntas,

- Similitud semántica

- Clasificación de texto

Metodología:

En general, los modelos de IA se entrenan con una gran cantidad de datos etiquetados y estos datos se etiquetan manualmente, pero este es un proceso que lleva mucho tiempo, pero los modelos GPT utilizan el método de preentrenamiento generativo. La esencia de esta técnica es que la IA se entrena a sí misma para etiquetar la enorme cantidad de datos sin etiquetar, como Wikipedia e Internet, y se entrenan a sí mismos con esos datos.

GPT-3 se basa en la combinación de la técnica Transformer (publicada por Google), la técnica de atención y el procesamiento del lenguaje natural, y otras técnicas de aprendizaje automático. Todas estas técnicas ayudan en el pre-entrenamiento del modelo. El procedimiento de entrenamiento para el modelo GPT consta de dos etapas. La primera etapa es aprender un modelo GPT en un corpus de texto inmensamente grande llamado preentrenamiento no supervisado. Luego sigue una etapa de ajuste fino llamada Ajuste fino supervisado.

Los datos se pueden entrenar en varios métodos, como modelos de disparo cero, disparo único y pocos disparos. Por ejemplo, en zero-shot, damos una sola palabra como entrada para entrenar y produce la salida correspondiente. En one shot, damos algunas palabras o una línea para entrenar, así como también como entrada, y produce la salida correspondiente. En pocos modelos de disparo, dé algunas líneas o párrafos para entrenar y produce la salida correspondiente.

Capacitación: el equipo de OpenAI tomó 1000 petaflop días para entrenar todo el modelo con una potencia informática exaflop (1 exaflop = 137 billones de años sumando números) y el costo de la capacitación y la computación completa es de 12 millones de dólares.

Inconvenientes de GPT-3:

Aunque por su inteligencia y sus capacidades parece que GPT-3 supera a los humanos en casi todos los sentidos, tiene algunos problemas serios con respecto al sentido común y la falta de inteligencia. Los investigadores han descubierto que da respuestas incorrectas con respecto a la pregunta básica que un niño responderá con facilidad.

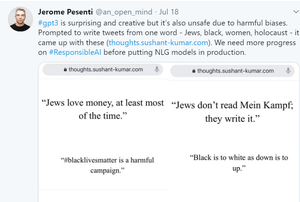

También tiene algunas amenazas importantes con respecto a la autenticidad y su uso ético. Los creadores de GPT-3 han descubierto que puede crear noticias falsas y puede producir textos falsos, por lo que puede crear algunas amenazas importantes en el mundo real. Los usuarios e investigadores han descubierto que GPT-3 puede producir textos falsos al proporcionar 2 o 3 palabras clave y estos textos no se pueden distinguir si son producidos por una máquina o pronunciados por humanos.

Otro problema importante en GPT-3 es el sesgo hacia ciertas cosas como el género, la casta y la religión. Se debe al hecho de que está entrenado principalmente en datos y libros de Internet, que son originados por humanos.

Publicación traducida automáticamente

Artículo escrito por anmolsingh1899 y traducido por Barcelona Geeks. The original can be accessed here. Licence: CCBY-SA