En este artículo, discutiremos cómo seleccionar la última fila y acceder al marco de datos de pyspark por índice.

Creando dataframe para demostración:

Python3

# importing module

import pyspark

# importing sparksession from pyspark.sql module

from pyspark.sql import SparkSession

# creating sparksession and giving an app name

spark = SparkSession.builder.appName('sparkdf').getOrCreate()

# list of students data

data = [["1","sravan","vignan"],

["2","ojaswi","vvit"],

["3","rohith","vvit"],

["4","sridevi","vignan"],

["1","sravan","vignan"],

["5","gnanesh","iit"]]

# specify column names

columns = ['student ID','student NAME','college']

# creating a dataframe from the lists of data

dataframe = spark.createDataFrame(data,columns)

# show dataframe

dataframe.show()

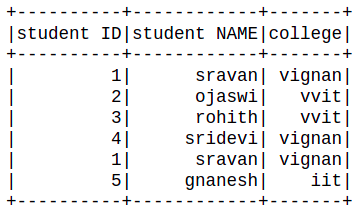

Producción:

Seleccione la última fila del marco de datos

Ejemplo 1: Uso de la función tail().

Esta función se utiliza para acceder a la última fila del marco de datos

Sintaxis: dataframe.tail(n)

dónde

- n es el número de filas a seleccionar desde la última.

- dataframe es el dataframe de entrada

Podemos usar n = 1 para seleccionar solo la última fila.

Ejemplo 1: Selección de la última fila.

Python3

# access last row of the dataframe dataframe.tail(1)

Producción:

[Row(student ID=’5′, student NAME=’gnanesh’, college=’iit’)]

Ejemplo 2: programa de Python para acceder a las últimas N filas.

Python3

# access last 5 rows of the # dataframe dataframe.tail(5)

Producción:

[Row(student ID='2', student NAME='ojaswi', college='vvit'), Row(student ID='3', student NAME='rohith', college='vvit'), Row(student ID='4', student NAME='sridevi', college='vignan'), Row(student ID='1', student NAME='sravan', college='vignan'), Row(student ID='5', student NAME='gnanesh', college='iit')]

Acceda al marco de datos por índice de columna

Aquí vamos a seleccionar el marco de datos en función del número de columna. Para seleccionar una columna específica usando el número de columna en el marco de datos pyspark, estamos usando la función select()

Sintaxis : dataframe.select(dataframe.columns[column_number]).show()

dónde,

- marco de datos es el nombre del marco de datos

- dataframe.columns[]: es el método que puede tomar el número de columna como entrada y seleccionar esa columna

- La función show() se usa para mostrar la columna seleccionada

Ejemplo 1: programa de Python para acceder a la columna según el número de columna

Python3

# select column with column number 1 dataframe.select(dataframe.columns[1]).show()

Producción:

+------------+ |student NAME| +------------+ | sravan| | ojaswi| | rohith| | sridevi| | sravan| | gnanesh| +------------+

Ejemplo 2: acceder a varias columnas en función del número de columna, aquí vamos a seleccionar varias columnas mediante el uso del operador de división, puede acceder hasta n columnas

Sintaxis: dataframe.select(dataframe.columns[column_start:column_end]).show()

donde: column_start es el índice inicial y column_end es el índice final.

Python3

# select column with column number slice # operator dataframe.select(dataframe.columns[0:3]).show()

Producción:

Publicación traducida automáticamente

Artículo escrito por gottumukkalabobby y traducido por Barcelona Geeks. The original can be accessed here. Licence: CCBY-SA