En este artículo, crearemos un programa para convertir una imagen en blanco y negro, es decir, una imagen en escala de grises, en una imagen en color. Vamos a utilizar el modelo de coloración Caffe para este programa. Y debe estar familiarizado con las funciones y usos básicos de OpenCV, como leer una imagen o cómo cargar un modelo previamente entrenado usando el módulo dnn, etc. Ahora analicemos el procedimiento que seguiremos para implementar el programa.

Pasos:

- Cargue el modelo y los puntos de convolución/núcleo

- Leer y preprocesar la imagen.

- Genere predicciones del modelo usando el canal L de nuestra imagen de entrada

- Use el canal de salida -> ab para crear una imagen resultante

¿Qué es el canal L y el canal ab? Básicamente, como el espacio de color RGB , hay algo similar, conocido como espacio de color Lab . Y esta es la base sobre la que se asienta nuestro programa. Hablemos brevemente de qué se trata:

¿Qué es el espacio de color de laboratorio?

Al igual que RGB, el color de laboratorio tiene 3 canales L, a y b. Pero aquí, en lugar de valores de píxeles, estos tienen diferentes significados, es decir:

- Canal L: intensidad de la luz

- un canal: codificación verde-roja

- canal b: codificación azul-rojo

Y en nuestro programa, usaremos el canal L de nuestra imagen como entrada a nuestro modelo para predecir los valores del canal ab y luego volver a unirlo con el canal L para generar nuestra imagen final.

A continuación se muestra la implementación de todos los pasos que he mencionado anteriormente.

Implementación:

Python3

import numpy as np

import cv2

from cv2 import dnn

#--------Model file paths--------#

proto_file = 'Model\colorization_deploy_v2.prototxt'

model_file = 'Model\colorization_release_v2.caffemodel'

hull_pts = 'Model\pts_in_hull.npy'

img_path = 'images/img1.jpg'

#--------------#--------------#

#--------Reading the model params--------#

net = dnn.readNetFromCaffe(proto_file,model_file)

kernel = np.load(hull_pts)

#-----------------------------------#---------------------#

#-----Reading and preprocessing image--------#

img = cv2.imread(img_path)

scaled = img.astype("float32") / 255.0

lab_img = cv2.cvtColor(scaled, cv2.COLOR_BGR2LAB)

#-----------------------------------#---------------------#

# add the cluster centers as 1x1 convolutions to the model

class8 = net.getLayerId("class8_ab")

conv8 = net.getLayerId("conv8_313_rh")

pts = kernel.transpose().reshape(2, 313, 1, 1)

net.getLayer(class8).blobs = [pts.astype("float32")]

net.getLayer(conv8).blobs = [np.full([1, 313], 2.606, dtype="float32")]

#-----------------------------------#---------------------#

# we'll resize the image for the network

resized = cv2.resize(lab_img, (224, 224))

# split the L channel

L = cv2.split(resized)[0]

# mean subtraction

L -= 50

#-----------------------------------#---------------------#

# predicting the ab channels from the input L channel

net.setInput(cv2.dnn.blobFromImage(L))

ab_channel = net.forward()[0, :, :, :].transpose((1, 2, 0))

# resize the predicted 'ab' volume to the same dimensions as our

# input image

ab_channel = cv2.resize(ab_channel, (img.shape[1], img.shape[0]))

# Take the L channel from the image

L = cv2.split(lab_img)[0]

# Join the L channel with predicted ab channel

colorized = np.concatenate((L[:, :, np.newaxis], ab_channel), axis=2)

# Then convert the image from Lab to BGR

colorized = cv2.cvtColor(colorized, cv2.COLOR_LAB2BGR)

colorized = np.clip(colorized, 0, 1)

# change the image to 0-255 range and convert it from float32 to int

colorized = (255 * colorized).astype("uint8")

# Let's resize the images and show them together

img = cv2.resize(img,(640,640))

colorized = cv2.resize(colorized,(640,640))

result = cv2.hconcat([img,colorized])

cv2.imshow("Grayscale -> Colour", result)

cv2.waitKey(0)

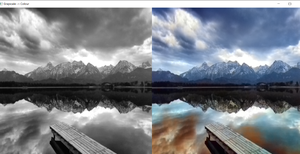

Producción:

fuente de la imagen pexels -imagen de stock libre

¿Que sigue?

Puede intentar leer el artículo de investigación original que implementó esta técnica: http://richzhang.github.io/colorization/ o puede crear su propio modelo en lugar de usar un modelo previamente entrenado.

Publicación traducida automáticamente

Artículo escrito por bobde_yagyesh y traducido por Barcelona Geeks. The original can be accessed here. Licence: CCBY-SA