En este artículo, veremos cómo verificar si TensorFlow está usando GUP o no.

Las GPU son la nueva norma para el aprendizaje profundo. Las GPU tienen una mayor cantidad de núcleos lógicos a través de los cuales pueden alcanzar un mayor nivel de paralelización y pueden proporcionar mejores y más rápidos resultados de cómputo en comparación con las CPU. Al igual que en las tareas de aprendizaje profundo, la cantidad de parámetros a entrenar puede llegar a miles de millones. Como sabemos, en una red neuronal para ajustar el peso se realizan operaciones de array, como la multiplicación de arrays, que es una operación costosa para realizar en una CPU. Para realizar estas operaciones múltiples más rápidas, es necesario realizarlas simultáneamente. La GPU tiene un mejor soporte de paralelización y también la memoria requerida para los modelos de aprendizaje profundo también es enorme y puede ser adecuada para una GPU.

Es posible que tenga una GPU, pero es posible que su modelo no la esté usando. En este caso, el entrenamiento se realizará en la CPU por defecto. Por lo tanto, es necesario verificar si Tensorflow está ejecutando la GPU que se le proporcionó.

Si desea saber si TensorFlow está usando la aceleración de GPU o no, simplemente podemos usar el siguiente comando para verificar.

Python3

import tensorflow as tf

tf.config.list_physical_devices('GPU')

Producción:

La salida debe mencionar una GPU. Los modelos tf.keras, si la GPU está disponible, se ejecutarán de manera predeterminada en una sola GPU. Si desea utilizar varias GPU, puede utilizar una estrategia de distribución.

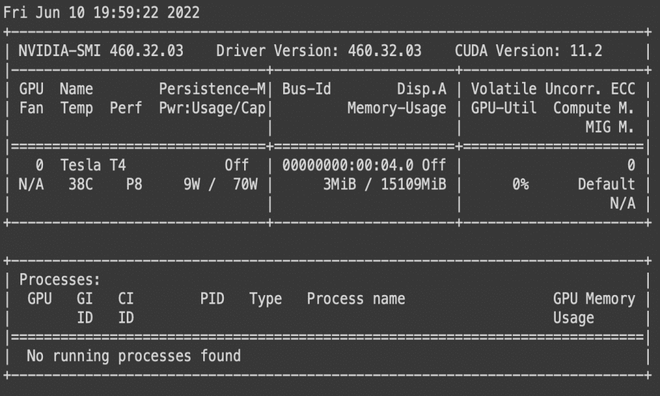

Una vez que obtenga esta salida, vaya a la terminal y escriba » nvidia-smi «. Es una utilidad de línea de comandos destinada a monitorear los dispositivos GPU de NVIDIA. Se basa en la parte superior de la Biblioteca de administración de Nvidia (NVML). Al escribir, debería producir algo similar a esto.

nvidia-smi

Este comando devolverá una tabla que consta de la información de la GPU en la que se ejecuta Tensorflow. Contiene información sobre el tipo de GPU que está utilizando, su rendimiento, uso de memoria y los diferentes procesos que está ejecutando. Para saber si su modelo ML se está entrenando en la GPU, simplemente anote la identificación del proceso de su modelo y compárela con la pestaña de procesos de la tabla dada. Si el modelo se ejecuta en la GPU, será una identificación de proceso del modelo mencionado en la pestaña de procesos.

También puede establecer el registro del dispositivo en verdadero para saber a qué dispositivos están asignados sus operaciones y tensores. Esto le permitirá saber qué GPU está realizando sus operaciones y almacenando los resultados.

tf.depuración.set_log_device_placement(Verdadero)

Esto debería devolver » Ejecutando op _EagerConst en dispositivo /trabajo:localhost/réplica:0/tarea:0/dispositivo:GPU:0 «

Comprobar los dispositivos disponibles para TensorFlow

Python3

from tensorflow.python.client import device_lib print(device_lib.list_local_devices())

Producción:

[name: "/device:CPU:0"

device_type: "CPU"

memory_limit: 268435456

locality {

}

incarnation: 13414683734401945856

xla_global_id: -1

]

Publicación traducida automáticamente

Artículo escrito por sahilgangurde08 y traducido por Barcelona Geeks. The original can be accessed here. Licence: CCBY-SA