Como sabemos, el aprendizaje Ensemble ayuda a mejorar los resultados del aprendizaje automático al combinar varios modelos. Este enfoque permite la producción de un mejor rendimiento predictivo en comparación con un solo modelo. La idea básica es aprender un conjunto de clasificadores (expertos) y permitirles votar. Bagging y Boosting son dos tipos de Ensemble Learning . Estos dos disminuyen la varianza de una sola estimación ya que combinan varias estimaciones de diferentes modelos. Así que el resultado puede ser un modelo con mayor estabilidad. Entendamos estos dos términos de un vistazo.

- Embolsado : es un modelo homogéneo de alumnos débiles que aprenden unos de otros de forma independiente en paralelo y los combinan para determinar el promedio del modelo.

- Impulso : también es un modelo homogéneo de alumnos débiles, pero funciona de manera diferente al embolsado. En este modelo, los alumnos aprenden de forma secuencial y adaptativa para mejorar las predicciones del modelo de un algoritmo de aprendizaje.

Veamos ambos en detalle y comprendamos la diferencia entre embolsar y aumentar.

Harpillera

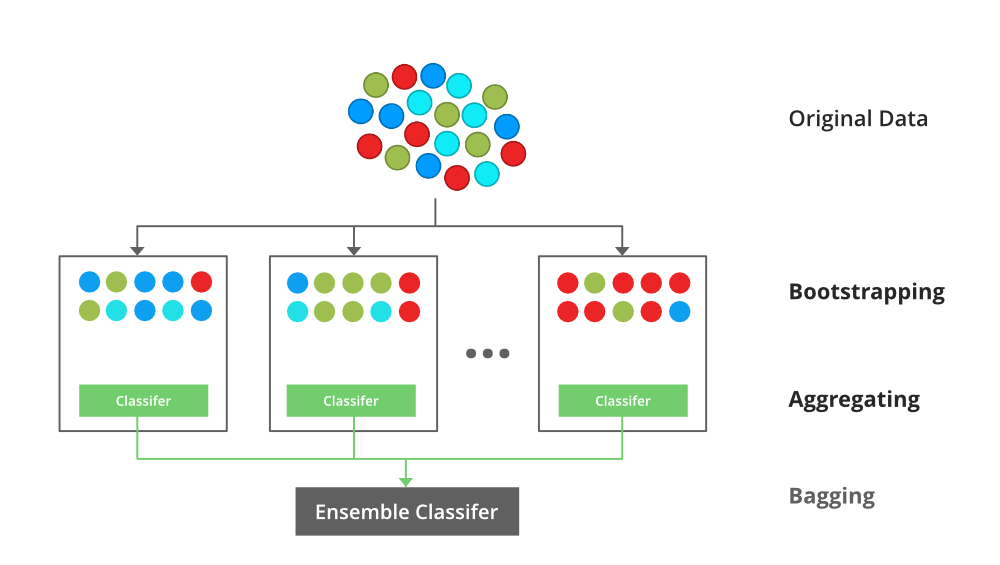

B ootstrap A ggregating, también conocido como embolsado, es un meta-algoritmo de conjunto de aprendizaje automático diseñado para mejorar la estabilidad y precisión de los algoritmos de aprendizaje automático utilizados en la clasificación y regresión estadística. Disminuye la varianza y ayuda a evitar el sobreajuste . Por lo general, se aplica a los métodos de árboles de decisión . El embolsado es un caso especial del enfoque de promedio del modelo.

Descripción de la Técnica

Supongamos que un conjunto D de d tuplas, en cada iteración i, se selecciona un conjunto de entrenamiento Di de d tuplas a través del muestreo de filas con un método de reemplazo (es decir, puede haber elementos repetitivos de diferentes d tuplas) de D (es decir, bootstrap) . Luego se aprende un modelo clasificador Mi para cada conjunto de entrenamiento D < i. Cada clasificador Mi devuelve su predicción de clase. El clasificador embolsado M* cuenta los votos y asigna la clase con más votos a X (muestra desconocida).

Pasos de implementación del embolsado

- Paso 1: Se crean múltiples subconjuntos a partir del conjunto de datos original con tuplas iguales, seleccionando observaciones con reemplazo.

- Paso 2: Se crea un modelo base en cada uno de estos subconjuntos.

- Paso 3: cada modelo se aprende en paralelo con cada conjunto de entrenamiento y de forma independiente entre sí.

- Paso 4: Las predicciones finales se determinan combinando las predicciones de todos los modelos.

Ejemplo de embolsado

El modelo Random Forest utiliza Bagging, donde están presentes modelos de árboles de decisión con mayor varianza. Hace una selección aleatoria de características para hacer crecer árboles. Varios árboles aleatorios forman un bosque aleatorio.

Para leer más, consulte este artículo: Clasificador de embolsado

impulsar

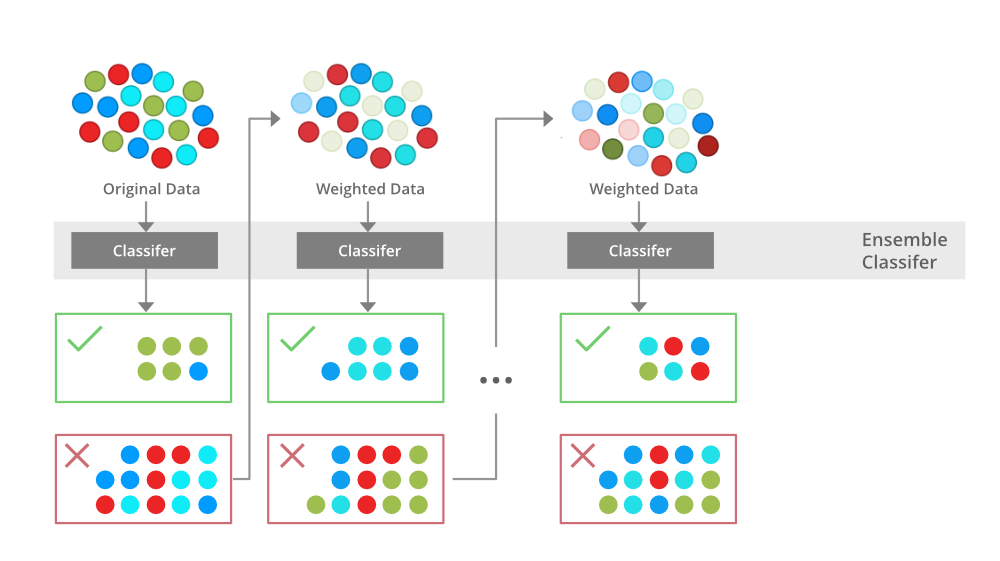

Boosting es una técnica de modelado de conjuntos que intenta construir un clasificador fuerte a partir del número de clasificadores débiles. Se realiza construyendo un modelo utilizando modelos débiles en serie. En primer lugar, se construye un modelo a partir de los datos de entrenamiento. Luego se construye el segundo modelo que trata de corregir los errores presentes en el primer modelo. Este procedimiento continúa y se agregan modelos hasta que se pronostica correctamente el conjunto completo de datos de entrenamiento o se agrega el número máximo de modelos.

Algoritmos de impulso

Hay varios algoritmos de refuerzo. Los originales, propuestos por Robert Schapire y Yoav Freund , no eran adaptativos y no podían aprovechar al máximo a los alumnos débiles. Schapire y Freund luego desarrollaron AdaBoost , un algoritmo de impulso adaptativo que ganó el prestigioso Premio Gödel. AdaBoost fue el primer algoritmo de impulso realmente exitoso desarrollado con el propósito de la clasificación binaria. AdaBoost es la abreviatura de Adaptive Boosting y es una técnica de impulso muy popular que combina múltiples «clasificadores débiles» en un solo «clasificador fuerte».

Algoritmo:

- Inicialice el conjunto de datos y asigne el mismo peso a cada uno de los puntos de datos.

- Proporcione esto como entrada al modelo e identifique los puntos de datos clasificados incorrectamente.

- Aumente el peso de los puntos de datos mal clasificados y disminuya el peso de los puntos de datos correctamente clasificados. Y luego normalice los pesos de todos los puntos de datos.

- if (obtuvo los resultados requeridos)

Ir al paso 5

else

Ir al paso 2- Final

Para leer más, consulte este artículo: Boosting y AdaBoost en ML

Similitudes entre el embolsado y el impulso

El embolsado y el impulso, siendo ambos los métodos comúnmente utilizados, tienen una similitud universal de ser clasificados como métodos de conjunto. Aquí vamos a explicar las similitudes entre ellos.

- Ambos son métodos de conjunto para obtener N alumnos de 1 alumno.

- Ambos generan varios conjuntos de datos de entrenamiento mediante muestreo aleatorio.

- Ambos toman la decisión final promediando los N alumnos (o tomando la mayoría de ellos, es decir, Votación Mayoritaria).

- Ambos son buenos para reducir la varianza y proporcionan una mayor estabilidad.

Diferencias entre embolsado y refuerzo

|

S.NO |

Harpillera |

impulsar |

|---|---|---|

| 1. | La forma más sencilla de combinar predicciones que pertenecen al mismo tipo. |

Una forma de combinar predicciones que pertenecen a los diferentes tipos. |

| 2. | Apunte a disminuir la varianza, no el sesgo. | Apunte a disminuir el sesgo, no la varianza. |

| 3. | Cada modelo recibe el mismo peso. | Los modelos se ponderan según su rendimiento. |

| 4. | Cada modelo se construye de forma independiente. | Los nuevos modelos están influenciados por el rendimiento de los modelos construidos previamente. |

| 5. | Los diferentes subconjuntos de datos de entrenamiento se seleccionan mediante el muestreo de filas con métodos de muestreo aleatorio y de reemplazo de todo el conjunto de datos de entrenamiento. | Cada nuevo subconjunto contiene los elementos que fueron mal clasificados por modelos anteriores. |

| 6. | El embolsado intenta resolver el problema del sobreajuste. | El impulso intenta reducir el sesgo. |

| 7. | Si el clasificador es inestable (alta varianza), aplique embolsado. | Si el clasificador es estable y simple (alto sesgo), se aplica el refuerzo. |

| 8. | En esta base, los clasificadores se entrenan paralelamente. | En esta base, los clasificadores se entrenan secuencialmente. |

| 9 | Ejemplo: el modelo de bosque aleatorio utiliza el embolsado. | Ejemplo: AdaBoost usa técnicas de Boosting |