Introducción:

La limpieza de datos es una de las partes importantes del aprendizaje automático. Desempeña un papel importante en la construcción de un modelo. Seguramente no es la parte más elegante del aprendizaje automático y, al mismo tiempo, no hay trucos ocultos ni secretos por descubrir. Sin embargo, el éxito o el fracaso de un proyecto depende de la limpieza adecuada de los datos. Los científicos de datos profesionales generalmente invierten una gran parte de su tiempo en este paso debido a la creencia de que «mejores datos superan a algoritmos más sofisticados» .

Si tenemos un conjunto de datos bien limpio, hay posibilidades de que podamos obtener buenos resultados también con algoritmos simples, lo que puede resultar muy beneficioso en ocasiones, especialmente en términos de cálculo cuando el tamaño del conjunto de datos es grande.

Obviamente, diferentes tipos de datos requerirán diferentes tipos de limpieza. Sin embargo, este enfoque sistemático siempre puede servir como un buen punto de partida.

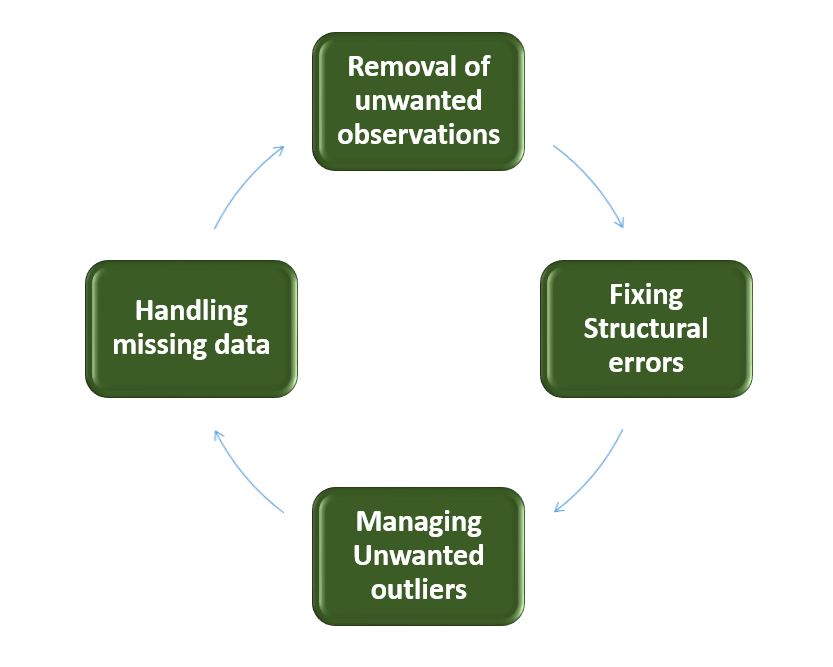

Pasos involucrados en la limpieza de datos:

- Eliminación de observaciones no deseadas

Esto incluye eliminar valores duplicados/redundantes o irrelevantes de su conjunto de datos. Las observaciones duplicadas surgen con mayor frecuencia durante la recopilación de datos y las observaciones irrelevantes son aquellas que en realidad no se ajustan al problema específico que está tratando de resolver.- Las observaciones redundantes alteran la eficiencia en gran medida a medida que los datos se repiten y pueden sumarse hacia el lado correcto o hacia el lado incorrecto, produciendo así resultados infieles.

- Las observaciones irrelevantes son cualquier tipo de dato que no nos sirve y que se puede eliminar directamente.

- Corrección de errores estructurales

Los errores que surgen durante la medición, la transferencia de datos u otras situaciones similares se denominan errores estructurales. Los errores estructurales incluyen errores tipográficos en el nombre de las características, el mismo atributo con un nombre diferente, clases mal etiquetadas, es decir, clases separadas que en realidad deberían ser iguales o mayúsculas inconsistentes.- Por ejemplo, el modelo tratará América y América como clases o valores diferentes, aunque representen el mismo valor o rojo, amarillo y rojo-amarillo como clases o atributos diferentes, aunque una clase se puede incluir en las otras dos clases. Entonces, estos son algunos errores estructurales que hacen que nuestro modelo sea ineficiente y den resultados de mala calidad.

- Gestión de valores atípicos no deseados

Los valores atípicos pueden causar problemas con ciertos tipos de modelos. Por ejemplo, los modelos de regresión lineal son menos resistentes a los valores atípicos que los modelos de árboles de decisión. En general, no debemos eliminar los valores atípicos hasta que tengamos una razón legítima para eliminarlos. A veces, eliminarlos mejora el rendimiento, a veces no. Por lo tanto, uno debe tener una buena razón para eliminar el valor atípico, como mediciones sospechosas que es poco probable que formen parte de datos reales. - Manejo de datos faltantes

Los datos faltantes son un problema engañosamente complicado en el aprendizaje automático. No podemos simplemente ignorar o eliminar la observación que falta. Deben manejarse con cuidado, ya que pueden ser una indicación de algo importante. Las dos formas más comunes de lidiar con los datos faltantes son:- Descartar observaciones con valores faltantes.

- El hecho de que faltara el valor puede ser informativo en sí mismo.

- Además, en el mundo real, a menudo necesita hacer predicciones sobre nuevos datos, incluso si faltan algunas de las características.

- Imputación de los valores faltantes de observaciones pasadas.

- Nuevamente, la «ausencia» casi siempre es informativa en sí misma, y debe decirle a su algoritmo si falta un valor.

- Incluso si crea un modelo para imputar sus valores, no está agregando ninguna información real. Solo está reforzando los patrones ya proporcionados por otras funciones.

- Descartar observaciones con valores faltantes.

La falta de datos es como perder una pieza del rompecabezas. Si lo deja caer, es como pretender que la ranura del rompecabezas no está allí. Si lo imputas, es como tratar de sacar una pieza de otro lugar del rompecabezas.

Por lo tanto, los datos que faltan son siempre informativos y una indicación de algo importante. Y debemos ser conscientes de nuestro algoritmo de datos faltantes marcándolo. Al usar esta técnica de marcado y llenado, esencialmente está permitiendo que el algoritmo estime la constante óptima para la falta, en lugar de simplemente completarla con la media.

Algunas herramientas de limpieza de datos

- Refinar abierto

- Wrangler Trifacta

- Claridad TIBCO

- Nublando

- Etapa de calidad de IBM Infosphere

Conclusión:

Entonces, hemos discutido cuatro pasos diferentes en la limpieza de datos para hacer que los datos sean más confiables y producir buenos resultados. Después de completar correctamente los pasos de limpieza de datos, tendremos un conjunto de datos sólido que evita muchas de las trampas más comunes. Este paso no debe apresurarse, ya que resulta muy beneficioso en el proceso posterior.