La selección de características, también conocida como selección de atributos, es un proceso de extracción de las características más relevantes del conjunto de datos y luego la aplicación de algoritmos de aprendizaje automático para un mejor rendimiento del modelo. Una gran cantidad de características irrelevantes aumenta el tiempo de entrenamiento exponencialmente y aumenta el riesgo de sobreajuste.

Prueba de chi-cuadrado para extracción de características: la prueba

de chi-cuadrado se usa para características categóricas en un conjunto de datos. Calculamos Chi-cuadrado entre cada característica y el objetivo y seleccionamos el número deseado de características con las mejores puntuaciones de Chi-cuadrado. Determina si la asociación entre dos variables categóricas de la muestra reflejaría su asociación real en la población.

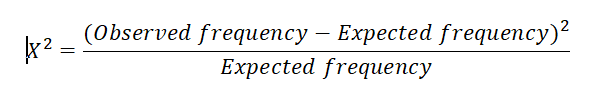

La puntuación de chi-cuadrado viene dada por:

donde –

Frecuencia observada = No. de observaciones de clase

Frecuencia esperada = No. de observaciones esperadas de clase si no hubiera relación entre la característica y el objetivo.

Implementación de Python de la selección de características de Chi-Square:

# Load libraries

from sklearn.datasets import load_iris

from sklearn.feature_selection import SelectKBest

from sklearn.feature_selection import chi2

# Load iris data

iris_dataset = load_iris()

# Create features and target

X = iris_dataset.data

y = iris_dataset.target

# Convert to categorical data by converting data to integers

X = X.astype(int)

# Two features with highest chi-squared statistics are selected

chi2_features = SelectKBest(chi2, k = 2)

X_kbest_features = chi2_features.fit_transform(X, y)

# Reduced features

print('Original feature number:', X.shape[1])

print('Reduced feature number:', X_kbest.shape[1])

Producción:

Original feature number: 4 Reduced feature number : 2

Publicación traducida automáticamente

Artículo escrito por aakarsha_chugh y traducido por Barcelona Geeks. The original can be accessed here. Licence: CCBY-SA